Web kazıma

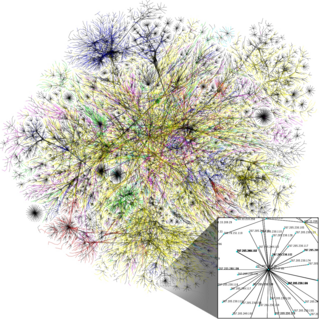

Web kazıma (web hasat veya web veri çekimi), web sitelerinden bilgi çıkartmanın bilgisayar programı tekniğidir. Çoğunlukla, bu tür yazılım programları düşük seviye Köprü Metni Aktarım Protokolü (HTTP) veya Mozilla Firefox gibi tam teşekküllü gömülü web tarayıcısı tarafından World Wide Web'in insan araştırmaları simüle edilir.

Web kazıma, web indeksleme ile yakından ilgilidir, web'de hangi bilgi indekslenmişse bir bot ya da web gezgini kullanılmıştır ve bu çoğu arama motoru tarafından benimsenen evrensel bir tekniktir. Buna karşılık, web kazıma genellikle web'de HTML biçimindeki yapılandırılmamış verilerin dönüşümüne odaklanır, yapılandırılmış veriler merkezi yerel veritabanında ya da tablolarda analiz edilip saklanabilir. Web kazıma aynı zamanda web otomasyonuyla ilgilidir, insan taramasının simüle edilmesi bilgisayar programı kullanılarak yapılır. Web kazımanın kullanımı, online fiyat karşılaştırması, iletişim bilgileri kazımı, hava durumu takibi, website değişikliklerinin bulunması, web mashup ve web bilgi entegrasyonunu içerir.

Web kazıma yakından çoğu arama motorları tarafından benimsenen evrensel bir tekniktir bot veya web tarayıcımızın kullanarak web'de dizine bilgileri ve web indeksleme ile ilgilidir. Buna karşılık, web kazıma merkezi yerel veritabanı veya elektronik saklanır ve analiz edilebilir yapılandırılmış veri içine, genellikle HTML biçiminde, web üzerinde yapılandırılmamış verilerin dönüşümü daha fazla odaklanıyor. Web kazıma ayrıca bilgisayar yazılımı kullanılarak insan tarama taklit web otomasyon ile ilgilidir. Web kazıma Kullanımı Online fiyat karşılaştırma, iletişim kazıma, hava durumu verileri izleme, web sitesi değişikliği algılama, araştırma, web mashup ve web veri entegrasyonu yer alıyor.

Teknikler

Web kazıma otomatik World Wide Web'den bilgi toplama işlemidir. Bu semantik web vizyonu, hala metin işleme, anlamsal anlayış, yapay zeka ve insan-bilgisayar etkileşiminde devrimler gerektiren iddialı bir girişim ile ortak hedefe paylaşan aktif gelişmelerin bir alandır. Mevcut web kazıma çözümleri tamamen sınırlamalar, yapılandırılmış bilgi içine tüm web sitelerini dönüştürmek mümkün otomatik sistemlere kadar, insan çaba gerektiren, reklam hoc arasında değişir.

- İnsan kopyalama ve yapıştırma: Bazen en iyi web kazıma teknolojisi insanın manuel muayene ve kopyalama ve yapıştırma yerini alamaz ve bazen bu tek uygulanabilir çözüm olabilir zaman açıkça makine otomasyonu önlemek için engelleri kurmak kazıma için web siteleri.

- Metin grepping ve düzenli ifade eşleşmesi: web sayfalarından bilgileri ayıklamak için basit ama güçlü bir yaklaşım UNIX grep komutuyla ya da (örneğin Perl veya Python için)Programlama dillerinin düzenli ifade eşleştirme tesislerine dayalı olabilir.

- HTTP programlama : Statik ve dinamik web sayfaları soket programlama kullanarak uzak web sunucusuna HTTP isteklerini göndererek alınabilir .

- HTML ayrıştırıcıları : Birçok web sitesi bir veritabanı gibi altta yatan yapısal bir kaynaktan dinamik olarak oluşturulan sayfaların büyük koleksiyonları var. Aynı kategorideki verileri genellikle ortak bir komut dosyası veya şablon benzer sayfalarına kodlanmıştır. Bir sargı denir veri madenciliği, belli bir bilgi kaynağı gibi şablonlar algılayan bir program, içeriği ayıklar ve ilişkisel forma çevirir. Sarıcı nesil algoritmaları bir sarmalayıcı indüksiyon sistemi giriş sayfaları ortak şablona uygun ve kolayca bir URL ortak düzeni açısından tespit edilebilir varsayalım. Ayrıca, bu tür XQuery ve HTQL gibi bazı yarı yapılandırılmış veri sorgulama dilleri, HTML sayfaları ayrıştırmak ve almak ve sayfa içeriği dönüştürmek için kullanılabilir.

- DOM ayrıştırma : Internet Explorer veya Mozilla tarayıcısı kontrolü gibi tam teşekküllü bir web tarayıcı, gömme, programlar istemci tarafı komut tarafından oluşturulan dinamik içeriği alabilirsiniz. Bu tarayıcı kontrolleri de programların sayfalarının parçalarını almak hangi dayalı bir DOM ağacına web sayfalarını ayrıştırmak.

- Web kazıma yazılım: Web kazıma çözümleri özelleştirmek için kullanılabilecek birçok yazılım araçları vardır. Bu yazılım otomatik olarak sayfanın veri yapısını tanımak veya saklayabilirsiniz elle web kazıma kod yazmak için gerekliliğini ya da özü ve içeriği dönüştürmek için kullanılabilecek bazı betik fonksiyonları ve veri tabanı arayüzleri kaldıran bir kayıt arabirimi sağlamak için deneyebilir yerel veritabanlarında kazınarak verileri.

- Dikey kümelenme platformları: Dikey belirli hasat platformları geliştirdik birkaç şirket var. Bu platformlar oluşturmak ve hayır " döngüde adam" (doğrudan insan müdahalesi) ve belirli bir hedef sitesi ile ilgili herhangi bir çalışma ile belirli dikey için " bot" çok sayıda monitör. Hazırlık tüm dikey ve ardından platformu botlar otomatik olarak oluşturur için bilgi tabanını oluşturulması içerir. Platformun sağlamlığı (o yüzlerce ya da binlerce site kadar ölçeklendirilebilir nasıl hızlı) o alır bilgilerin (alanların genellikle sayı) ve ölçeklenebilirlik kalitesi ile ölçülür. Bu ölçeklenebilirlik çoğunlukla ortak toplayan karmaşık veya çok emek-yoğun hasat içeriğine bulmak sitelerin Long Tail hedeflemek için kullanılır.

- Semantik açıklama tanıyarak : özgü veri parçacıkları bulmak için kullanılabilecek meta veya anlamsal işaretlerini ve açıklamaları kucaklamak olabilir kazınarak olan sayfalar. Açıklamalar sayfalarında gömülü ise Microformat yaptığı gibi, bu teknik DOM ayrıştırma özel bir durum olarak görülebilir. Başka bir durumda, bir semantik katmana halinde organize ek açıklamalar, saklanır ve web sayfalarından ayrı olarak yönetilen, yani sıyırıcılar sayfalarını kazıma önce bu katmanda veri şema ve talimatları alabilirsiniz .

- Bilgisayar vizyon web sayfası analiz: tanımlamak ve bir insan olarak görsel sayfaları yorumlayarak web sayfalarından bilgileri ayıklamak girişimi makine öğrenme ve bilgisayar vizyonu ile çalışmalar vardır olabilir.[1]

Yasal sorunlar

Web kazıma bazı web sitelerinin kullanım koşullarını aykırı olabilir. Bu terimlerin uygulanabilirliği belirsizdir. Orijinal ifadenin düpedüz çoğaltılması birçok durumda yasadışı olacak olsa, Amerika Birleşik Devletleri mahkemeleri gerçeklerin çoğaltılması izin olduğunu Feist Yayınları v. Kırsal Telefon Hizmeti karar verdi. ABD mahkemeleri "kazıyıcı" veya "robotlar" nin kullanıcıların kazıyıcı kullanıcı geçmeleri ise bunun üzerine kendisinin kişisel mülkiyet kabul ediliyor, bir bilgisayar sistemi gerektirir taşınır için haneye tecavüz, işlemekten sorumlu olabileceğini kabul etmektedir. En iyi bu gibi durumlarda bilinen, eBay v. Teklif Sahibinin Kenar, toplama, erişen durdurmak için bir tedbir sipariş Teklif Sahibinin Edge sonuçlandı ve eBay web sitesinden indeksleme ihaleleri. Bu durum ihale sniping olarak bilinen tekliflerin otomatik yerleştirerek, içeriyordu. Ancak, taşınır için haneye tecavüz iddiası üzerine başarılı olmak için, davacı davalı kasten ve izinsiz bilgisayar sisteminde davacının sahiplik ilgi ile ve sanığın izinsiz kullanımı davacıya zarar olduğunu müdahale olduğunu göstermek zorundadır. Mahkemeler taşınır için suç olarak kabul edilmiştir önce değil, web spidering tüm olgular getirdi.[2]

Ekranın ilk önemli testlerden biri American Airlines (AA) dahil ve FareChase adında bir firma kazıma. AA başarıyla da AA'nın web sitesini arar eğer çevrimiçi tarifeleri karşılaştırmak olanak tanır yazılım satan farechase durdurma, Texas mahkemesinin bir emir aldı. Havayolu kamuya açık verileri toplamış zaman farechase en websearch yazılım AA'nın sunucularında tecavüz savundu. FareChase Haziran farechase tarafından 2003 yılı Mart ayında bir temyiz başvurusunda ve AA yerleşmeye karar verdiler ve temyiz düştü.[3]

Southwest Airlines ayrıca ekran kazıma uygulamaları meydan ve farechase ve yasal iddia başka bir firma, Outtask, hem de yer vardır. Southwest Airlines o "Bilgisayar Dolandırıcılığı ve Kötüye" bir örneğidir ve "Hasar ve Zarar" ve Southwest'in sitenin "Yetkisiz Erişim" yol açmıştır çünkü ekran kazıma Yasadışı olduğunu suçladı. Aynı zamanda "İş İlişkileri Girişim", "İzinsiz" ve "Bilgisayar sağlığa zararlıdır Erişim" oluşturmaktadır. Onlar da ekran kazıma yasal "zimmete para geçirme ve Sebepsiz zenginleşme", yanı sıra web sitesinin kullanıcı sözleşmesi ihlal olarak bilinen teşkil ettiğini iddia etti. Outtask Bu durumda hakim kanun ABD Telif hakkı yasası ve telif hakkı altında, bilgi parçaları telif hakkı korumasına tabi olmayacaktır kazınarak varlık olduğunu olması gerektiğini iddia ederek, tüm bu iddiaları yalanladı. Davalar, Amerika Birleşik Devletleri Yüksek Mahkemesi giderilmiş asla rağmen, FareChase sonunda ana şirket Yahoo tarafından kepenkli edildi ! ve Outtask seyahat gideri şirketi hemfikir tarafından satın alındı. 2012 yılında, 3Taps adında bir başlangıç Craigslist adlı gizli konut reklamları kazınmış. Craigslist 3Taps-kes ve-vazgeçmek mektup göndermiş ve onların IP adreslerini bloke daha sonra Craigslist v. 3Taps olarak, dava açtı. Mahkeme Craigslist düzgün 3Taps olduğunu Bilgisayar Dolandırıcılık ihlal ve Kötüye Kullanma Yasası vardı iddia etmek için ateşkes ve-vazgeçmek mektup ve IP engelleme yeterli olduğuna karar vermiştir.

Bu erken kazıma kararlar ve sorumluluk teorileri üniforma olmasa da, bu mahkemelerin bu tür sitelerin sahiplerine istenmeyen kullanımlar ticari sitelerde özel içeriği korumak için hazır olduklarını ortaya bir model göz ardı etmek zordur. Ancak, bu tür içerik için koruma derecesi yerleşmiş değildir ve raspa tarafından yapılan erişim türüne bağlıdır, bilgi miktarı erişilebilir ve kopyalanamaz, derecesi erişimi olumsuz sitesi sahibinin sistemi ve türleri ve etkileri böyle davranış üzerindeki yasaklar şekilde.[4]

Bu alanda yasa daha yerleşmiş olur iken, kişiler hakkında da bu tür eylem kullanımı ve diğer şartlar veya bildirimler yayınlanan veya site aracılığıyla sunulan koşullarını gözden tarafından yetkilendirilmiş olup olmadığını düşünmelisiniz kamu web sitesine erişmek için kazıma programları kullanılarak düşünürken. Cvent, Inc v bir 2010 kararında. Eventbrite, Inc Virginia doğu bölgesi için Amerika Birleşik Devletleri bölge mahkemesi, mahkeme kullanım koşulları bir browse için için kullanıcıların dikkatine getirdi gerektiğine hükmetti şal sözleşmesi veya lisans uygulanmak üzere. Pennsylvania Doğu Bölgesi ABD Bölge Mahkemesi açılan bir 2014, yılında, e-ticaret sitesi QVC gerçek zamanlı fiyatlandırma verilerine QVC sitesinin Pinterest benzeri bir alışveriş toplayıcı Resultly en kazıma itiraz. QVC Resultly QVC perakende sitesi QVC için kayıp satış sonuçlanır iki gün çökmesine QVC sitesini neden (sözde Dakikada 36.000 isteklerine bazen dakikada QVC web sitesine 200-300 arama istekleri göndererek) "aşırı sürünerek" diye allges. QVC yaptığı şikayet davalı kaynak IP adresini maskelemek için web tarayıcısını gizlenmiş ve böylece hızlı bir şekilde sorunu tamir dan QVC engelledi iddia etmektedir. QVC QVC iddiaları Resultly neden oldu kendi web sitesi, kullanılamaması için tazminat istiyor çünkü bu özellikle ilginç kazıma durumdur.

Kullanım link şartları internet üzerindeki en siteleri gibi sayfanın altındaki sitenin tüm bağlantıları, içinde görüntülenen bu davanın döneminde davacının web sitesinde. Bu iktidar aşağıda açıklanan İrlandalı kararı çelişmektedir. Mahkeme ayrıca göz şal kısıtlamaları Düzgün Bilgisayar Enformasyon İşlemleri Yasası (UCITA )birçok ortak göz şal müteahhitlik uygulamaları konusunda lehine olduğuna inanıyordu -a üniforma hukuku Virginia'nın kabul görünümünde uygulanabilir olduğu davacının iddiasını reddetmiştir.[5]

Amerika Birleşik Devletleri dışında, 2006 yılı Şubat ayında, Danimarka Denizcilik ve Ticaret Mahkemesi (Kopenhag )Home.dk Danimarkalı yasa veya çakışmaması emlak sitesi portal sitesi OfiR.dk sistematik taranmasına, indeksleme ve derin bağlama hükmetti Avrupa Birliği direktifi veritabanı.[6]

2009 yılında Facebook bilinen bir web kazıyıcı karşı ilk telif takım elbise birini kazandı. Bu mahkemelerin internette olduğu gibi adil kullanım adlandırılan elimden doğrudan telif hakkı ihlali ve çok net parasal zararlar En son durumda olmak AP v erime suyundan oluşan, birlikte kazıma herhangi bir web kravat sayısız davalar için zemin hazırlamıştır.[7]

Şubat yargı konularında karmaşık 2.010 dava, İrlanda'nın Yüksek Mahkemesi içtihatlarını geliştirme inchoate durumunu gösteren bir karar verdi. Ryanair Ltd v Billigfluege.de GmbH şirketinin durumunda, İrlanda'nın Yüksek Mahkemesi yasal olarak bağlayıcı olmasını Ryanair " click- wrap " anlaşması hükmetti. ABD Bölge Mahkemesi Doğu Virginia Bölge ve Danimarka Denizcilik ve Ticaret Mahkemesi bu bulgular aksine, Sayın Adalet Michael Hanna Ryanair'ın hüküm ve koşullara köprü açıkça görünür oldu ve o hükmetti üzerinde yükümlülüklerini de ortadan yerleştirerek kullanıcı bir sözleşme ilişkisi içermesi yeterlidir çevrimiçi hizmetlere erişmek amacıyla şartları ve koşulları kabul etmek. Karar İrlanda'nın Yargıtay'da temyiz aşamasındadır .I[8]

Avustralya, Spam Yasası 2003 haydutlar web hasat bazı formları, bu sadece e-posta adreslerine de geçerlidir rağmen [9][10]

Kayda değer araçları

Teknik önlemler botlara durdurmak için

Bir web sitesinin yöneticisi durdurmak veya bot yavaş çeşitli önlemler kullanabilirsiniz. Bazı teknikler şunlardır:

- Bir IP adresi ya elle ya da Geolocation ve DNSRBL gibi kriterlere göre engelleme. Bu aynı zamanda bu adrese gelen tüm tarama engeller. Web sitesinin sistem altında bırakabilecek herhangi bir web servis API devre dışı bırakılması. Botlar bazen (kullanıcı aracısı dizeleri kullanarak) ve (robots.txt kullanarak) bu temelde bloke edilebilir kim beyan; 'Googlebot' bir örnektir. Diğer botlar kendileri ve bir tarayıcı kullanarak bir insanın arasında hiçbir ayrım yapmak. Botlar aşırı trafik izleme tarafından bloke edilebilir. Botlar bazen bir kaptan gibi site erişen gerçek bir kişi olduğunu doğrulamak için araçları ile bloke edilebilir. Botlar bazen açıkça belli CAPTCHA kalıplarını kırmak için kodlanmış veya okumak ve CAPTCHA zorlukları gerçek zamanlı olarak cevap insan emeğini kullanan üçüncü taraf hizmetleri istihdam edebilir. Ticari anti-bot hizmetleri: Firmalar, anti-bot ve web siteleri için hizmet anti-kazıma sunuyoruz. Birkaç web uygulama güvenlik duvarları yanı sıra bot algılama yetenekleri sınırlıdır. Bir bal küpü veya başka bir yöntemle botlar yerlerinin otomatik tarayıcılarının IP adreslerini tespit etmek. Gizleme okuyucu kullanıcıları ekrana erişilebilirlik pahasına, telefon numaraları veya e-posta adresleri gibi verileri görüntülemek için CSS sprite kullanarak. Botlar bir bot ilk kurulumunda daha insani katılımını gerektirir önemli verileri ve navigasyon elemanları çevreleyen HTML / CSS küçük varyasyonları ekleme ve etkin bir hale getirebilir yapılırsa, hedef web sitesinin ön uç kod tutarlılık dayandıklarından nedeniyle kazıma işlemini otomatikleştirmek için azalmış yeteneği kazımak için çok zor bir web sitesi hedef.

Makaleler

Web Kazıma : Bilmeniz Wanted (ama sormak korktular) Her şey [11]

Teknikler

Web kazıma otomatik olarak World Wide Web üzerinden bilgi toplama işlemidir. Mevcut web kazıma çözümleri, ad-hoc, insan çabası gerektiren, tüm websitelerini yapılandırılmış verilere dönüştüren tam otomatik sistemler ve bazı sınırlamalar arasındadır.

- İnsan kopyalaması ve yapıştırması: Bazen en iyi web kazıma teknolojisi bile insanın manuel incelemesini ve kopyalama ve yapıştırmalarının yerini alamaz ve web kazımaya karşı bir engel varsa bazen bu tek uygulanabilir çözüm olabilir.

- Metin araması ve düzenli ifade eşleşmesi: Web sayfalarından bilgileri ayıklamak için basit ama güçlü bir yaklaşım olan UNIX'in grep komutuyla ya da programlama dillerinin (örneğin Perl veya Python) düzenli ifade eşleştirme tesislerine dayalı olabilir.

- HTTP programlama: Statik ve dinamik web sayfaları soket programlama kullanarak uzak web sunucusuna HTTP isteklerini göndererek alınabilir.

- HTML ayrıştırıcıları: Birçok web sitesi bir veritabanı gibi altta yatan yapısal bir kaynaktan dinamik olarak oluşturulan sayfaların büyük koleksiyonları olabilir. Aynı kategorideki veriler genellikle ortak bir komut dosyası veya şablona benzer sayfalar olarak kodlanmıştır. Veri madenciliğinde, bir program belirli bir bilgi kaynağındaki bu tür şablonları bulur, içeriği ayıklar ve sarıcı denilen ilişkisel forma çevrilir. Ayrıca, XQuery gibi bazı yarı yapılandırılmış veri sorgulama dilleri ile HTML ayrıştırılabilir ve sayfa içeriği dönüştürülmek için kullanılabilir.

- DOM ayrıştırma: Programlar, Internet Explorer veya Mozilla gibi tam teşekküllü gömülü web tarayıcılarıyla istemci scriptleri tarafından oluşturulan dinamik içerikleri alabilir. Bu browser kontrolleri DOM ağacından sayfaları ayırabilir, herhangi bir program sayfalardan bu parçaları alabilir.

- Web kazıma yazılımları: Bazı yazılım araçları özelleştirilebilir web kazıma çözümleri sunar. Bu yazılımlar sayfanın yapısını otomatik olarak tanıyabilir, elle web kazıma kodları yazma zorunluluğunu ortadan kaldıran arayüzler, içeriği çıkartmak ve dönüştürmek için bazı script fonksiyonları ve kazılmış içeriği yerel veritabanına kaydetmek için veritabanı arayüzleri sağlayabilir.

- Dikey toplama platformları: Bazı şirketler web kazıma platformları geliştirmiştir. Bu platformlar, insan müdahalesi olmayan bazı dikeyler için çok sayıda "bot" üretir ve gözler. Hiçbir çalışma belirli siteler için yapılmaz. Hazırlık, tüm dikeyler için bilgi tabanının kurulması ve sonra platformun botları otomatik olarak oluşturulmasını içerir.

- Bilgisayar görüşlü web sayfası analistleri: Bunlar makine öğrenimi ve bilgisayar görüşü kullanarak insan gibi yorumlanmış sayfa görsellerinden web sayfasındaki bilgileri görüntüler ve tanımlar.[1]

Tanınmış araçlar

Ayrıca bakınız

Kaynakça

- ^ a b Roush, Wade (25 Temmuz 2012). "Diffbot Is Using Computer Vision to Reinvent the Semantic Web". www.xconomy.com. 27 Nisan 2013 tarihinde kaynağından arşivlendi. Erişim tarihi: 15 Mart 2013.

- ^ "Ticketmaster Corp. v. Tickets.com, Inc." 20 Ağustos 2007. 28 Eylül 2007 tarihinde kaynağından arşivlendi. Erişim tarihi: 20 Ağustos 2007.

- ^ "American Airlines, FareChase Settle Suit". The Free Library. 13 Haziran 2003. 5 Mart 2016 tarihinde kaynağından arşivlendi. Erişim tarihi: 26 Şubat 2012.

- ^ Adler, Kenneth A. (29 Temmuz 2003). "Controversy Surrounds 'Screen Scrapers': Software Helps Users Access Web Sites But Activity by Competitors Comes Under Scrutiny". 11 Şubat 2011 tarihinde kaynağından arşivlendi. Erişim tarihi: 27 Ekim 2010.

- ^ "Did Iqbal/Twombly Raise the Bar for Browsewrap Claims?" (PDF). 17 Eylül 2010. 23 Temmuz 2011 tarihinde kaynağından (PDF) arşivlendi. Erişim tarihi: 27 Ekim 2010.

- ^ "UDSKRIFT AF SØ- & HANDELSRETTENS DOMBOG" (PDF). bvhd.dk. 24 Şubat 2006. 12 Ekim 2007 tarihinde kaynağından (PDF) arşivlendi. Erişim tarihi: 30 Mayıs 2007.

- ^ "Is web scraping illegal depends on what the meaning of the word is is". 10 Ocak 2016 tarihinde kaynağından arşivlendi. Erişim tarihi: 9 Ocak 2016.

- ^ Matthews, Áine (Haziran 2010). "Intellectual Property: Website Terms of Use". Issue 26: June 2010. LK Shields Solicitors Update. s. 03. 24 Haziran 2012 tarihinde kaynağından arşivlendi. Erişim tarihi: 19 Nisan 2012.

- ^ National Office for the Information Economy (Şubat 2004). "Spam Act 2003: An overview for business" (PDF). Australian Communications Authority. s. 6. 21 Mayıs 2009 tarihinde kaynağından (PDF) arşivlendi. Erişim tarihi: 9 Mart 2009.

- ^ National Office for the Information Economy (Şubat 2004). "Spam Act 2003: A practical guide for business" (PDF). Australian Communications Authority. s. 20. 7 Nisan 2009 tarihinde kaynağından (PDF) arşivlendi. Erişim tarihi: 9 Mart 2009.

- ^ "Web Scraping: Everything You Wanted to Know (but were afraid to ask)". Distil Networks. 22 Temmuz 2015. 7 Kasım 2015 tarihinde kaynağından arşivlendi. Erişim tarihi: 4 Kasım 2015.