Metinden resme model

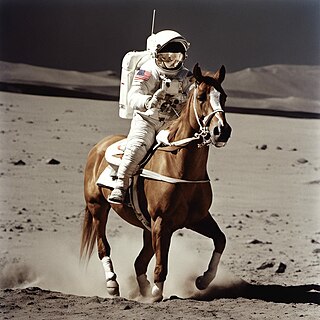

Metinden görüntüye model, girdi olarak bir metin açıklamasını alan ve bu tanıma uyan bir görüntü üreten bir makine öğrenim modelidir. Bu tür modeller, derin sinir ağlarındaki geliştirmelerin bir sonucu olarak 2010'ların ortalarında geliştirilmeye başlandı. 2022'de OpenAI'dan DALL-E 2, Google Brain'den Imagen ve StabilityAI'den Stable Diffusion gibi metinden resme modellerin çıktıları, gerçek fotoğrafların ve insan çizimlerinin kalitesine yaklaşmaya başladı.

Metinden görüntüye modeller genellikle girdi metnini gizli bir temsile dönüştüren bir dil modeli ile bu temsile bağlı bir görüntü üreten üretken bir görüntü modelini birleştirir. En etkili modeller genellikle web'den alınan büyük miktardaki resim ve metin verileriyle eğitilmiştir.[1]

Tarihi

Derin öğrenmenin ortaya çıkmasından önce, metinden görüntüye modeller oluşturma girişimleri, örneğin bir küçük resim veri tabanındaki mevcut bileşen görüntülerinin düzenlenmesiyle yapılan kolajlarla sınırlıydı.[2][3]

Ters görev olan görüntü altyazısı daha kolay takip edilebilirdi ve bir dizi görüntü altyazılı derin öğrenme modeli, ilk metinden görüntüye modellerden önce geldi.[4]

İlk modern metinden resme modeli olan alignDRAW, 2015 yılında Toronto Üniversitesi'nden araştırmacılar tarafından tanıtıldı. alignDRAW, daha önce tanıtılan DRAW mimarisini (bir dikkat mekanizmasına sahip tekrarlayan değişken bir otomatik kodlayıcı kullanan) metin dizilerine göre koşullandıracak şekilde genişletti.[4] alignDRAW tarafından oluşturulan görüntüler bulanıktı ve fotogerçekçi değildi, ancak model, eğitim verilerinde temsil edilmeyen nesnelere (kırmızı bir okul otobüsü gibi) genelleme yapabildi ve "mavi gökyüzünde bir dur işareti uçuyor" gibi yeni istemleri uygun şekilde ele aldı. ", bunun yalnızca eğitim setindeki verileri "ezberlemek" olmadığını gösteriyor.[5]

2016 yılında Reed, Akata, Yan ve ark. metinden resme görevi için üretken rakip ağları kullanan ilk kişi oldu.[5][6] Dar, alana özgü veri kümeleri üzerinde eğitilen modeller sayesinde, "belirgin, kalın, yuvarlak gagalı, tamamen siyah bir kuş" gibi metin başlıklarından kuşların ve çiçeklerin "görsel olarak makul" görüntülerini oluşturmayı başardılar. Daha çeşitli COCO veri seti üzerinde eğitilen bir model, "uzaktan... cesaret verici" görüntüler üretti, ancak ayrıntılarında tutarlılık yoktu.[5] Daha sonraki sistemler arasında VQGAN+CLIP,[7] XMC-GAN ve GauGAN2 bulunur.[8]

Kamuoyunun geniş ilgisini çeken ilk metinden görüntüye modellerden biri, Ocak 2021'de duyurulan bir transformatör sistemi olan OpenAI'nin DALL-E'siydi.[9] Daha karmaşık ve gerçekçi görüntüler oluşturabilen bir halef olan DALL-E 2, Nisan 2022'de tanıtıldı[10] ve ardından Ağustos 2022'de halka açık Stable Diffusion yayınlandı.[11]

Kaynakça

- ^ Vincent, James (24 Mayıs 2022). "All these images were generated by Google's latest text-to-image AI". The Verge (İngilizce). 15 Şubat 2023 tarihinde kaynağından arşivlendi. Erişim tarihi: 16 Aralık 2023.

- ^ Agnese, Jorge; Herrera, Jonathan; Tao, Haicheng; Zhu, Xingquan (Temmuz 2020). "A survey and taxonomy of adversarial neural networks for text‐to‐image synthesis". WIREs Data Mining and Knowledge Discovery (İngilizce). 10 (4). doi:10.1002/widm.1345. ISSN 1942-4787. 16 Aralık 2023 tarihinde kaynağından arşivlendi. Erişim tarihi: 16 Aralık 2023.

- ^ Zhu, Xiaojin; Goldberg, Andrew B.; Eldawy, Mohamed; Dyer, Charles R.; Strock, Bradley (2007). "A text-to-picture synthesis system for augmenting communication 7 Eylül 2022 tarihinde Wayback Machine sitesinde arşivlendi." (PDF). AAAI. 7: 1590–1595.

- ^ a b Mansimov, Elman; Parisotto, Emilio; Ba, Jimmy; Salakhutdinov, R. (9 Kasım 2015). "Generating Images from Captions with Attention". CoRR. 16 Aralık 2023 tarihinde kaynağından arşivlendi. Erişim tarihi: 16 Aralık 2023.

- ^ a b c Reed, Scott; Akata, Zeynep; Logeswaran, Lajanugen; Schiele, Bernt; Lee, Honglak (June 2016). "Generative Adversarial Text to Image Synthesis 16 Mart 2023 tarihinde Wayback Machine sitesinde arşivlendi." (PDF). International Conference on Machine Learning.

- ^ Frolov, Stanislav; Hinz, Tobias; Raue, Federico; Hees, Jörn; Dengel, Andreas (1 Aralık 2021). "Adversarial text-to-image synthesis: A review". Neural Networks. 144: 187-209. doi:10.1016/j.neunet.2021.07.019. ISSN 0893-6080. 5 Kasım 2023 tarihinde kaynağından arşivlendi. Erişim tarihi: 16 Aralık 2023.

- ^ Rodriguez, Jesus (27 Eylül 2022). "🌅 Edge#229: VQGAN + CLIP". TheSequence. 4 Aralık 2022 tarihinde kaynağından arşivlendi. Erişim tarihi: 16 Aralık 2023.

- ^ Rodriguez, Jesus (4 Ekim 2022). "🎆🌆 Edge#231: Text-to-Image Synthesis with GANs". TheSequence. 4 Aralık 2022 tarihinde kaynağından arşivlendi. Erişim tarihi: 16 Aralık 2023.

- ^ Coldewey, Devin (5 Ocak 2021). "OpenAI's DALL-E creates plausible images of literally anything you ask it to". TechCrunch (İngilizce). 5 Ocak 2021 tarihinde kaynağından arşivlendi. Erişim tarihi: 16 Aralık 2023.

- ^ Coldewey, Devin (6 Nisan 2022). "New OpenAI tool draws anything, bigger and better than ever". TechCrunch (İngilizce). 6 Mayıs 2023 tarihinde kaynağından arşivlendi. Erişim tarihi: 16 Aralık 2023.

- ^ "Stable Diffusion Public Release". Stability AI (İngilizce). 16 Aralık 2023 tarihinde kaynağından arşivlendi. Erişim tarihi: 16 Aralık 2023.